Sommaire

NVIDIA présente son modèle IA NVLM 1.0 open-source

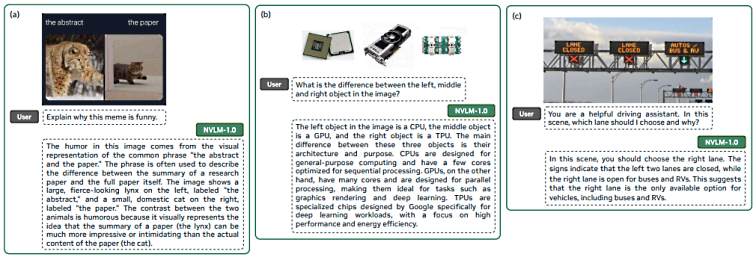

NVIDIA a récemment annoncé le lancement de son modèle d’intelligence artificielle (IA) open-source, le NVLM 1.0, qui pourrait potentiellement dépasser les performances du GPT-4 développé par OpenAI. Cette nouvelle famille de modèles de langage multimodaux, dont le modèle phare est le NVLM-D-72B, comprend environ 72 milliards de paramètres.

Performances avancées en vision-langage

Selon l’équipe de recherche de NVIDIA, le NVLM 1.0 excelle dans les tâches de vision-langage tout en maintenant et améliorant les performances par rapport aux modèles de langage standard. Les chercheurs de NVIDIA affirment : « Nous présentons le NVLM 1.0, une famille de modèles de langage multimodaux de pointe qui obtiennent des résultats remarquables dans les tâches de vision-langage, rivalisant avec les modèles propriétaires, notamment le GPT-4o, ainsi que d’autres modèles accessibles gratuitement. »

Amélioration continue des performances textuelles

Un aspect notable du NVLM-D-72B est sa capacité à améliorer sa précision de 4,3 points en moyenne sur les benchmarks textuels, contrairement à d’autres modèles propriétaires qui voient leurs performances déclinées au fil du temps. Ce modèle est également capable d’interpréter des graphiques et des tableaux, d’analyser des images, de décoder des logiciels et de résoudre des problèmes mathématiques.

Détails architecturaux et conception des modèles

Le 17 septembre 2024, NVIDIA a mis en avant la famille NVLM 1.0. Ce modèle se distingue par ses performances supérieures dans les tâches de vision-langage et pour le texte seul comparé à ses homologues classiques après une formation multimodale. NVIDIA a conçu une architecture innovante qui optimise à la fois l’efficacité de l’entraînement et les capacités de raisonnement multimodal.

Conception et ensembles de données

NVIDIA a élaboré une approche de tile-tagging 1-D pour les images haute résolution, améliorant ainsi les performances des tâches multimodales, y compris la reconnaissance optique des caractères (OCR). En ce qui concerne les données d’entraînement, la société a fourni des informations détaillées sur ses ensembles de données, soulignant que la qualité et la diversité des tâches sont essentielles pour toutes les architectures, même durant la phase de pré-entraînement. Le NVLM 1.0 a été conçu pour exceller dans des tâches variées de vision et de langage tout en renforçant ses performances dans les tâches uniquement textuelles.

Accès et utilisation de NVLM 1.0

NVIDIA partage les poids du modèle sur la plateforme Hugging Face et prévoit de publier prochainement le code d’entraînement accessible à la communauté. Cela permettra aux développeurs et chercheurs de tirer parti de cette technologie avancée dans leurs projets.

Résultats des tests et compatibilité

NVIDIA a formé le NVLM en utilisant l’ancienne base Megatron-LM, adaptant le code pour assurer la reproductibilité avec Hugging Face. Les résultats des benchmarks montrent une compétitivité marquée des performances du modèle sur différentes tâches multimodales par rapport aux autres modèles.

Chargement et inference du modèle

Le modèle peut être chargé sur plusieurs GPU pour une utilisation optimisée. Des instructions techniques détaillées sont fournies pour faciliter le travail des développeurs qui souhaitent expérimenter avec ce modèle IA puissant.

Licence et droits d’utilisation

Ce modèle est soumis à la licence CC BY-NC-4.0, qui permet un usage non commercial tout en respectant les droits d’auteur de NVIDIA.